| 命令: | 统计 协议和响应 协议和响应 互评者协议(kappa) 互评者协议(kappa) |

描述

根据电子表格中的原始数据为两个观察者创建一个分类表,并计算评估者之间的协议统计量(Kappa),以按序数或名义尺度评估两个分类之间的一致性。

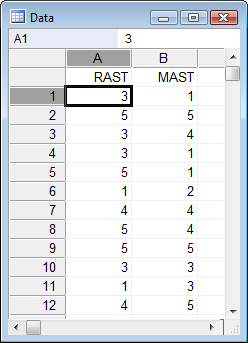

如何输入数据

此测试是对电子表格中的原始数据执行的。如果您已经将数据整理到表格中,则可以使用“测试”菜单中的“评分者之间的协议”命令。

必填项

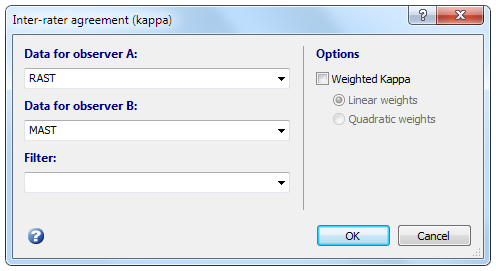

在“评分者之间的协议”对话框中,必须标识两个离散变量以及来自两个观察者的分类数据。分类数据可以是数字值或字母数字(字符串)值。

加权 Kappa

Kappa并未考虑观察者之间的分歧程度,所有分歧均被视为完全分歧。因此,在对类别进行排序时,最好使用加权Kappa(Cohen,1968年),并为评估者因i个类别而有所不同的主题分配不同的权重w i,以便不同程度的协议可以为Kappa的价值做出贡献。

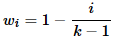

MedCalc提供了两组权重,称为线性和二次权重。在线性集中,如果有k个类别,则权重计算如下:

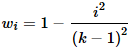

并在二次组中:

当有5个类别时,线性集的权重分别为0(=完全一致)或1、2、3和4个类别时,权重分别为1、0.75、0.50、0.25和0。在二次组中,权重为1、0.937、0.750、0.437和0。

当第一类别和第二类别之间的差异与第二类别和第三类别之间的差异具有相同的重要性时,请使用线性权重。如果第一类别和第二类别之间的差异不如第二类别和第三类别之间的差异重要,等,使用二次权重。

结果

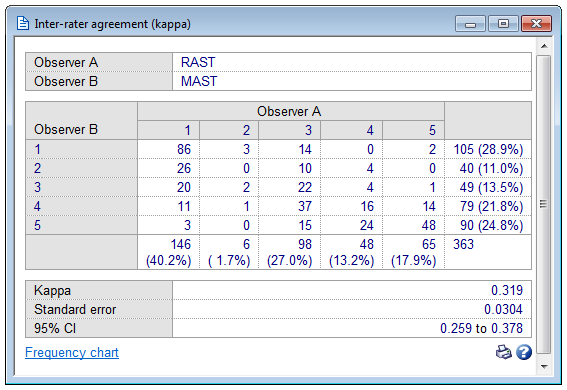

MedCalc根据Cohen,1960年计算出评估者间协议的统计值Kappa;根据Cohen,1968年计算得出的加权Kappa值。计算细节也在1991年的Altman(p。406-407)中给出。根据Fleiss等人(2003年)计算标准误和95%置信区间。

MedCalc报告的标准误差是适当的标准误差,用于测试以下假设:加权kappa的基础值等于非零的预先指定值(Fleiss等,2003)。

所述ķ值可以被解释为如下(奥特曼,1991):

| K值 | 协议强度 |

|---|---|

| <0.20 | 较差的 |

| 0.21-0.40 | 公平 |

| 0.41-0.60 | 中等 |

| 0.61-0.80 | 好 |

| 0.81-1.00 | 挺好 |