描述

使用“评分者之间的一致性”评估两个分类(名义或序数尺度)之间的一致性。

如果原始数据在电子表格中可用,请使用“统计”菜单中的“评分者之间的协议”来创建分类表并计算Kappa(Cohen 1960; Cohen 1968; Fleiss等人,2003)。

一致性由Kappa(K)统计量量化:

- 当分类系统之间完全吻合时, K为1

- 当没有协议比机会更好时, K为0

- 当一致性差于偶然性时, K为负。

必填项

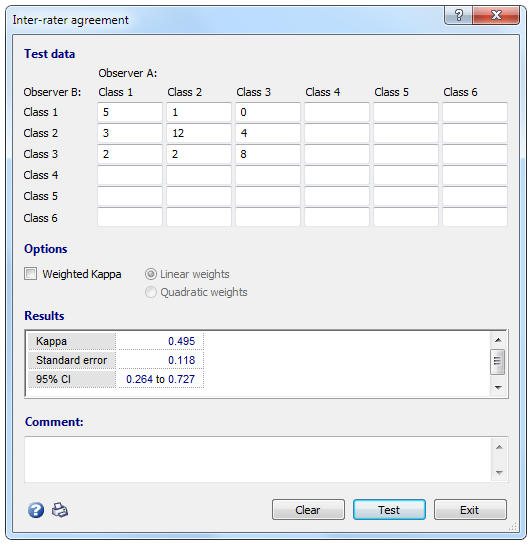

在对话框形式中,您可以在6×6频率表中输入两个分类系统。

如果数据来自有序刻度,请选择“加权卡伯”(Cohen 1968)。如果数据来自标称比例,则不要选择“加权卡伯”。

当第一类别和第二类别之间的差异与第二类别和第三类别之间的差异具有相同的重要性时,请使用线性权重。如果第一类别和第二类别之间的差异不如第二类别和第三类别之间的差异重要,等,使用二次权重。

在此示例中,从观察者B放置在类别1中的6个案例中,观察者A在类别1中放置了5个,在类别2中放置了1个;在观察者B置于第2类的19个案例中,观察者A在第1类中放置了3,在第2类中放置了12,在第3类中放置了4;从观察者B置于第3类的12个案例中,观察者A将1置于2类,将2置于第2类,将8置于第3类。

输入数据后,单击“测试”按钮。程序将显示Kappa的值及其标准错误和95%置信区间(CI)。

MedCalc根据Cohen,1960年计算出评估者间协议的统计值Kappa;并根据Cohen,1968年得出的加权Kappa。计算细节也见于Altman,1991年(第406-407页)。根据Fleiss等人(2003年)计算标准误和95%置信区间。

MedCalc报告的标准误差是适当的标准误差,用于检验以下假设:加权kappa的基础值等于零以外的预定值(Fleiss等,2003)。

所述ķ值可以被解释为如下(奥特曼,1991):

| K值 | 协议强度 |

|---|---|

| <0.20 | 较差的 |

| 0.21-0.40 | 公平 |

| 0.41-0.60 | 中等 |

| 0.61-0.80 | 好 |

| 0.81-1.00 | 挺好 |

在注释输入字段中,您可以输入将包含在打印报告中的注释或结论。